Deep Learning Toolbox 包含一系列算法、预训练模型和应用程序,为您设计和实现深度神经网络提供框架。您可以使用卷积神经网络 (ConvNet、CNN) 和长短期记忆 (LSTM) 网络,对图像、时间序列和文本数据执行分类和回归。您可以使用自动微分、自定义训练循环和共享权重构建网络架构,例如生成式对抗网络 (GAN) 和孪生网络。借助深度网络设计器,您能够以图形方式设计、分析和训练网络。试验管理器可帮助您管理多个深度学习实验、跟踪训练参数、分析结果,并比较来自不同实验的代码。您可以将层激活区域可视化,并以图形方式监控训练进度。

您可以从 TensorFlow™ 2、TensorFlow-Keras、PyTorch®、ONNX™(开放式神经网络交换)模型格式和 Caffe 中导入网络和层次图。您还可以将 Deep Learning Toolbox 网络和层次图导出为 TensorFlow 2 和 ONNX 模型格式。该工具箱支持基于 DarkNet-53、ResNet-50、NASNet、SqueezeNet 及其他多种预训练模型进行迁移学习。

您可以在单 GPU 或多 GPU 工作站上更快地训练模型(需要 Parallel Computing Toolbox),或者将运算扩展到集群和云,例如 NVIDIA® GPU Cloud 和 Amazon EC2® GPU 实例(需要 MATLAB Parallel Server)。

网络设计和模型管理

使用低代码 App 加速深度学习模型的开发。使用深度网络设计器创建、训练、分析和调试网络。使用试验管理器调节和比较多个模型。

预训练模型

在 MATLAB 中用一行代码访问常用的模型。通过 ONNX 和 TensorFlow™ 使用 PyTorch™ 将任何模型导入 MATLAB。

代码生成

使用 GPU Coder 自动生成优化的 CUDA® 代码,使用 MATLAB Coder 生成 C 和 C++ 代码,以将深度学习网络部署到 NVIDIA GPU 和各种处理器。使用 Deep Learning HDL Toolbox 在 FPGA 和 SoC 上进行深度学习网络的原型开发和实现。

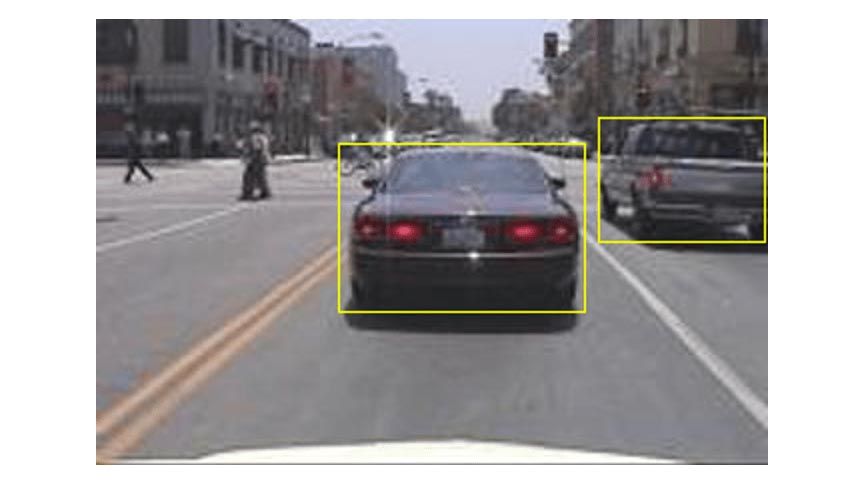

Simulink 仿真

使用控制、信号处理和传感器融合组件仿真深度学习网络,以评估深度学习模型对系统级性能的影响。

深度学习压缩

对您的深度学习网络进行量化和剪枝,以减少内存使用量并提高推断性能。使用深度网络量化器,对性能与推断准确性之间的权衡进行分析和可视化。