squeezenet

(不推荐)SqueezeNet 卷积神经网络

不推荐使用 squeezenet。请改用 imagePretrainedNetwork 函数。有关详细信息,请参阅版本历史记录。

说明

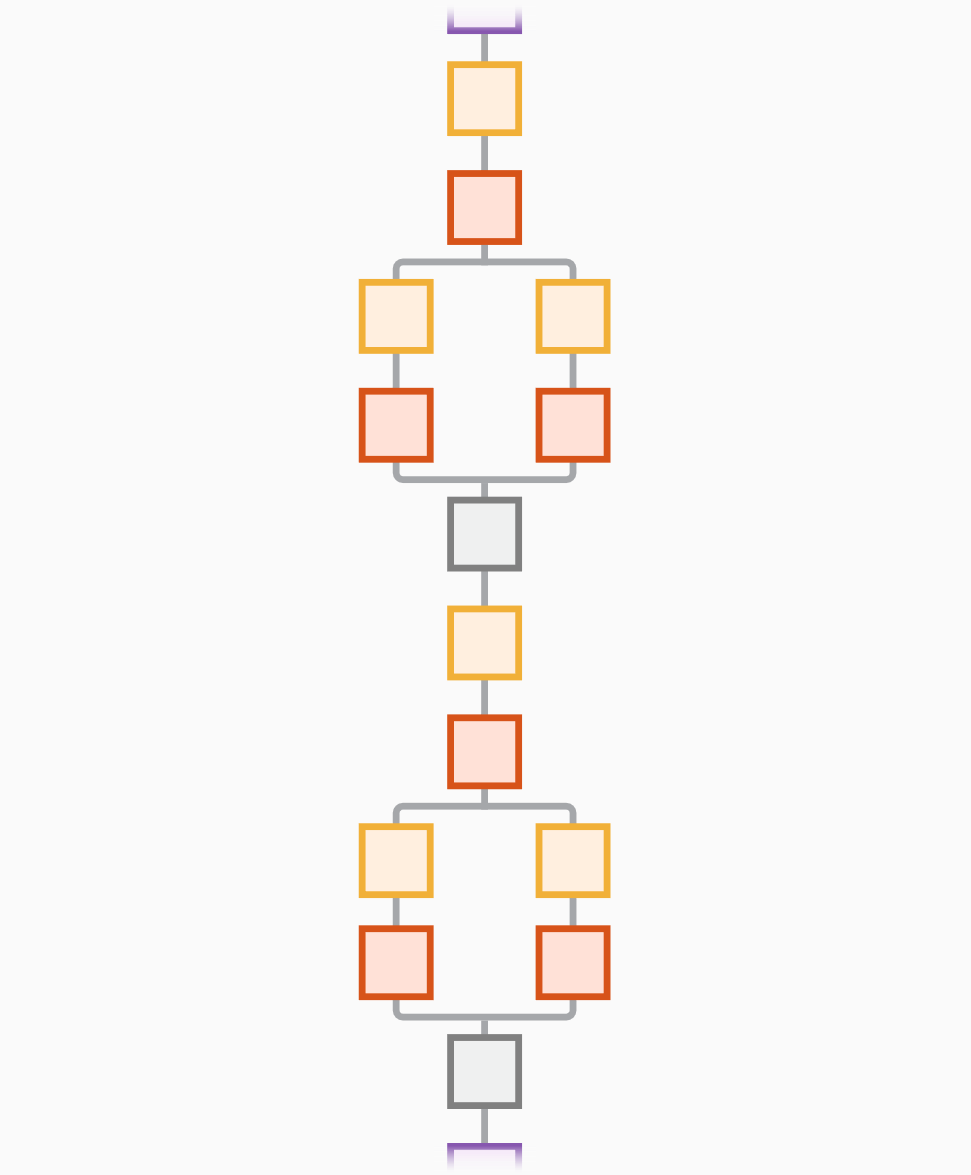

SqueezeNet 是深度为 18 层的卷积神经网络。您可以从 ImageNet 数据库 [1] 中加载该网络的预训练版本,该版本基于 ImageNet 数据库的超过一百万个图像进行训练。该预训练网络可以将图像分类至 1000 个目标类别(例如键盘、鼠标、铅笔和多种动物)。因此,该网络已基于大量图像学习了丰富的特征表示。此函数返回一个 SqueezeNet v1.1 网络,它具有与 SqueezeNet v1.0 相似的准确度,但每次预测需要更少的浮点运算 [3]。该网络的图像输入大小为 227×227。有关 MATLAB® 中预训练网络的详细信息,请参阅预训练的深度神经网络。

net = squeezenet('Weights','imagenet')net = squeezenet。

lgraph = squeezenet('Weights','none')

示例

输出参量

参考

[1] ImageNet. http://www.image-net.org.

[2] Iandola, Forrest N., Song Han, Matthew W. Moskewicz, Khalid Ashraf, William J. Dally, and Kurt Keutzer. “SqueezeNet: AlexNet-Level Accuracy with 50x Fewer Parameters and <0.5MB Model Size.” Preprint, submitted November 4, 2016. https://arxiv.org/abs/1602.07360.

[3] Iandola, Forrest N. "SqueezeNet." https://github.com/forresti/SqueezeNet.